Hızla dijitalleşen dünyada verilerin çokluğu, boyutu ve sürekli yeni verilerin eklenmesi ile hayatımızda büyük veri adını verdiğimiz sistem oluşmaya başladı. 2000’li yılların başında yapılan bir araştırmada, kitaplarda bulunan bilgilerin %20 kadarı internet ortamında bulunabilirken 2015 yılına geldiğimizde %98 oranında bilginin internet ortamına taşındığı fark edildi. Bu durum göz önüne alındığında insanların kullandıkları internet erişimli cihazlar, birbiri ile haberleşebilen cihazlar ve sanayi ortamlarında çalışan cihazlardan alınan verilerin de bir şekilde tek bir ortamda toplanabilmesi gerekmekteydi. Bu durumlar çerçevesinde büyük veri kavramı dijital işlemleri yapan, yorumlayan ve dönüştürenlerin hayatına girdi.

Büyük Veri ( Big Data )

Bilgi için çıkarılabilen ve makine öğrenimi projelerinde, tahmine dayalı modelleme ve diğer gelişmiş analitik uygulamalarda kullanılabilecek, kuruluşlar tarafından toplanan yapılandırılmış, yarı yapılandırılmış ve yapılandırılmamış veri kombinasyonlarıdır.

Büyük verileri işleyen ve depolayan sistemler, büyük veri analitiği kullanımını destekleyen araçlarla birlikte kuruluşlardaki veri yönetimi mimarilerinin ortak bir bileşeni haline geldi. Büyük veri genellikle ‘üç v’ olarak bilinir:

• Hacim ( Volume )

• Hız ( Velocity )

• Çeşitlilik ( Variety )

Büyük veri, belirli bir veri hacmine eşit olmasa da dağılımları genellikle zaman içinde oluşturulan ve toplanan gigabaytlar, petabaytlar ve daha büyük verileri içermektedir.

Büyük Verinin Önemi

Şirketler, pazar paylarını büyütebilmek, daha iyi müşteri hizmeti sağlamak, kişiselleştirilmiş pazarlama kampanyaları oluşturmak ve kârlarını arttırabilecek doğru adımları bulmak için büyük verileri kullanırlar.

Büyük Veri Örnekleri

Büyük Verileriler sayısız kaynaktan gelir. Müşteri veri tabanları, belgeler, e-postalar, tıbbi kayıtlar, internet tıklama akış günlükleri, mobil uygulamalar ve sosyal ağlar… Ayrıca ağ ve sunucu günlük dosyaları gibi makine tarafından oluşturulan verileri ve üretim makinelerindeki sensörlerden gelen verileri de içerir.

Büyük Veri Nasıl Saklanır ve İşlenir?

Veriler genellikle bulut ortamlarında bir diğer deyiş ile veri göllerinde depolanmaktadır. Veri ambarları genellikle ilişkisel veri tabanları üzerine kurulur ve yalnızca yapılandırılmış verileri içerirken, veri gölleri çeşitli veri türlerini destekler ve tipik olarak Hadoop kümelerine, bulut nesnesi depolama hizmetlerine, NoSQL veritabanlarına veya daha büyük veri platformlarına dayanır.

Birçok büyük veri ortamı, birden çok sistemi dağıtılmış bir mimaride birleştirir; örneğin, merkezi bir veri gölü, ilişkisel veritabanları veya bir veri ambarı dahil olmak üzere diğer platformlarla entegre edilebilir. Büyük veri sistemlerindeki veriler ham haliyle bırakılabilir ve daha sonra belirli analitik kullanımlar için gerektiği şekilde filtrelenip düzenlenebilir.

Büyük veri işleme, temel bilgi işlem altyapısına ağır talepler getirir. Gerekli bilgi işlem gücü, genellikle işleme iş yüklerini Hadoop ve Spark işleme motoru gibi teknolojileri kullanarak yüzlerce veya binlerce emtia sunucusuna dağıtan kümelenmiş sistemler tarafından sağlanır.

Bu tür bir işleme kapasitesini uygun maliyetli bir şekilde elde etmek zorlu bir iştir. Sonuç olarak; bulut, büyük veri sistemleri için popüler bir konumdur. Kuruluşlar, kendi bulut tabanlı sistemlerini devreye alabilir veya bulut sağlayıcılarının sunduğu yönetilen bir hizmet olarak büyük veri tekliflerini kullanabilir. Bulut kullanıcıları, büyük veri analizi projelerini tamamlamak için yeterli sayıda sunucuyu ölçeklendirebilir.

İşletme yalnızca kullandığı depolama ve işlem süresi için ödeme yapar ve bulut yeniden ihtiyaç duyulana kadar kapatılabilir.

Büyük veri analizi nasıl çalışır?

Büyük veri analitiği uygulamalarından geçerli ve alakalı sonuçları alabilmek için veri bilimcileri ve diğer veri analistleri mevcut veriler hakkında ayrıntılı bir anlayışa ve içinde ne aradıklarına dair bir fikre sahip olmalıdır. Bu, veri kümelerinin profilini oluşturma, temizleme, doğrulama ve dönüşümünü içeren veri hazırlığı, analitik sürecinde çok önemli bir ilk adım haline gelir.

Veriler toplanıp analiz için hazırlandıktan sonra, büyük veri analitiği özellikleri ve yetenekleri sağlayan araçlar kullanılarak farklı uygulamaları çalıştırmak için çeşitli veri bilimi ve gelişmiş analitik disiplinleri uygulanabilir. Bu disiplinler arasında makine öğrenimi ve onun derin öğrenme dalı, tahmine dayalı modelleme, veri madenciliği, istatistiksel analiz, akış analizi, metin madenciliği ve daha fazlası bulunmaktadır.

Büyük Veri Analizine Neden İhtiyacımız Var?

Yazının başından beri söz ettiğimiz gibi büyük verinin analizi şirketlerin yaşam döngülerinin devamlılığı ve insanların yönetim sistemleri içerisindeki geleceğini belirlemek için önemlidir. Dijitalleşen ve devamlı olarak insan sensör durumuna geldiğimiz çağda her saniye büyüyen veri bulutları ve içerisinde gerekli, gereksiz, doğru ve yanlış verileri ayırt etmek, ihtiyaca uygun verileri görebilmek için doğru şartlar ile analizler ortaya çıkartmamız gerekmektedir.

Büyük veriyi doğru analizi yaparak kullanan Netflix: “Elindeki veriler ile 77000 civarında film türü oluşturmuştur”.

House Of Cards dizisi yayınlanmak için uygun bir platform/kanal arayışındayken, Netflix elindeki büyük veriyi kullanarak yaptığı analizin neticesinde hazırladığı teklifle diğer yayın örgütlerini ciddi bir şekilde geride bırakarak 2 sezon için 100 Milyon Dolarlık bir ödeme yapmıştır. Netflix elindeki verilerden bu dizinin fazlası ile geri dönüş yapılacağını iyi bir şekilde analiz etmiştir. Ödeme yapıldıktan sonra işin promosyon kısmını da üstlenen Netflix, elindeki başarılı olmuş programların afişlerini de incelemeye başladı. Ellerindeki verilerden doğru tasarlanmış bir afişin bir içeriğe %20 ile %30 arasında müşteri getirdiğini öğrenmişlerdi.

House Of Cards, 2013 yılının ilk çeyreğinde Amerika Birleşik Devletleri’nde 2 milyon yeni abone ve diğer ülkelerde 1 milyon yeni aboneyi Netflix’e sağladı. Toplamda 3 milyon yeni abone ile Netflix yapmış olduğu 100 milyon dolarlık ödemeyi geri kazanmış oldu.’ (Dr. Sait Ölmez / Sabancı Üni. Müh. ve Doğa Bilim. Fakültesi Öğretim Üyesi // Büyük Veri ile Yeni Dünya)

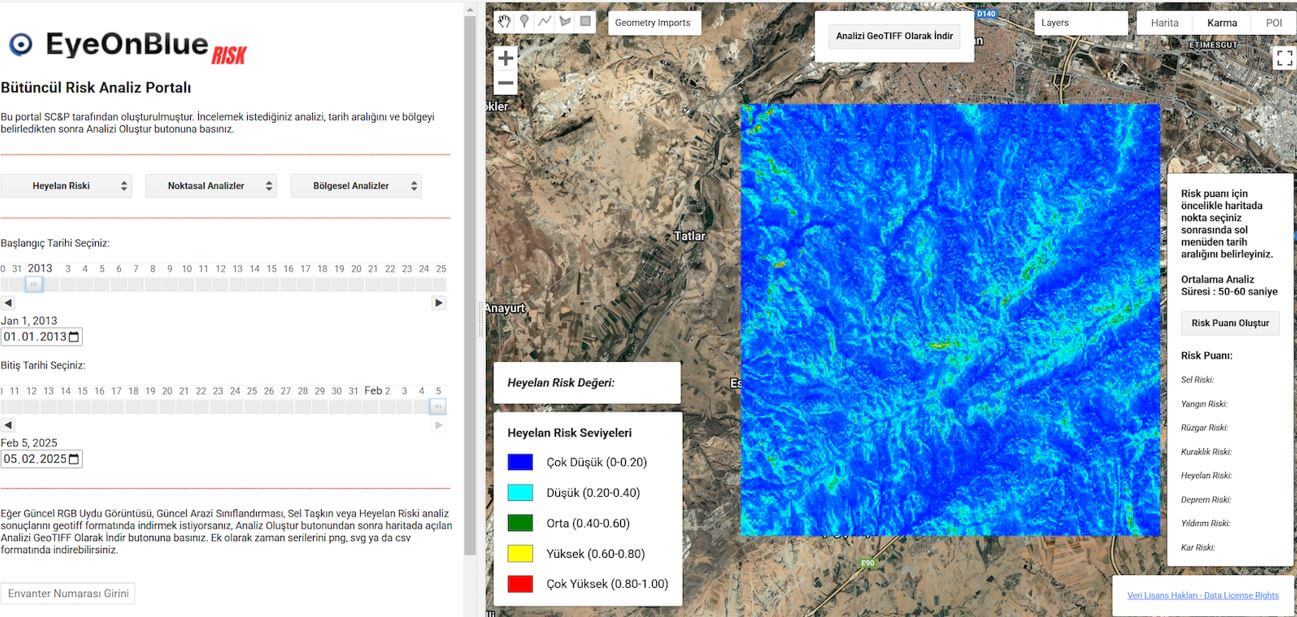

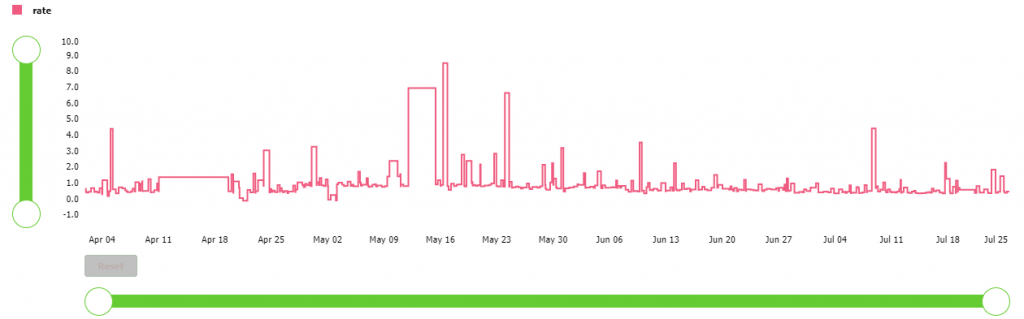

BrandIT Mühendislik ekibi olarak bizler de çalıştığımız iş ortaklıklarımızın fabrikalarındaki makinelerden aldığımız verileri PTC – Thingworx platformu ve yardımcı farklı platformlar ile analiz ederek zaman bazlı karşılaştırmalar hazırlanmasında, grafik izlenim çıkarmakta, anlık veri kontrolleri sağlayarak problemli işlemlerin tespit edilmesinde, anomali gibi değerlerin oluşturulmasında kullanarak şirketlerin verimliliğini arttırmaktayız. Verilerin doğru şekilde toplanması ve analiz edilmesini sağlayarak şirketlerin pazar paylarını büyütmelerini, maliyetlerini düşürmelerini ve daha düşük hurda oranları ile üretim yapmalarını sağlamaktayız.

Yukarıdaki örnekte hizmet vermekte olduğumuz gıda sektöründen bir firmadaki 3 aylık işlem oranlarının veri analizi grafiksel olarak gösterilmektedir. Toplanan anlık veriler ile sistem her an güncellenmekte bu sayede yukarıda sayılan faydaların gerçekleştirilmesinde ilgili firmaya destek olunmaktadır.

Yardımcı kaynak bilgileri:

https://searchbusinessanalytics.techtarget.com/definition/big-data-analytics

https://www.sas.com/en/whitepapers/bigdata-bigcompanies-106461.html

Dr. Sait Ölmez / Sabancı Üni. Müh. ve Doğa Bilim. Fakültesi Öğretim Üyesi // Büyük Veri ile Yeni Dünya

Olcay Emre Tok, BrandIT Mühendislik Yazılım Geliştirici